Community durchsuchen

Zeige Ergebnisse für die Stichwörter "'methodik'".

11 Ergebnisse gefunden

-

methodik Schmalband - Narrow band

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

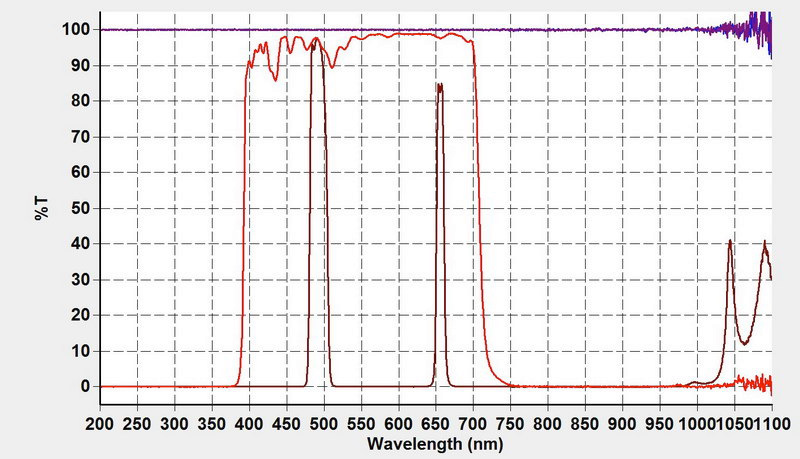

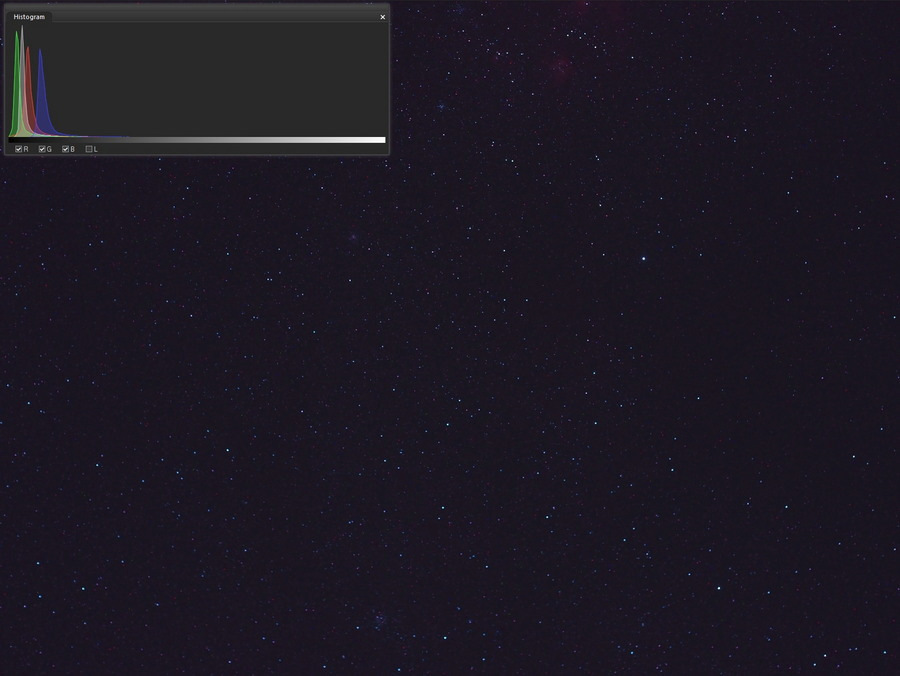

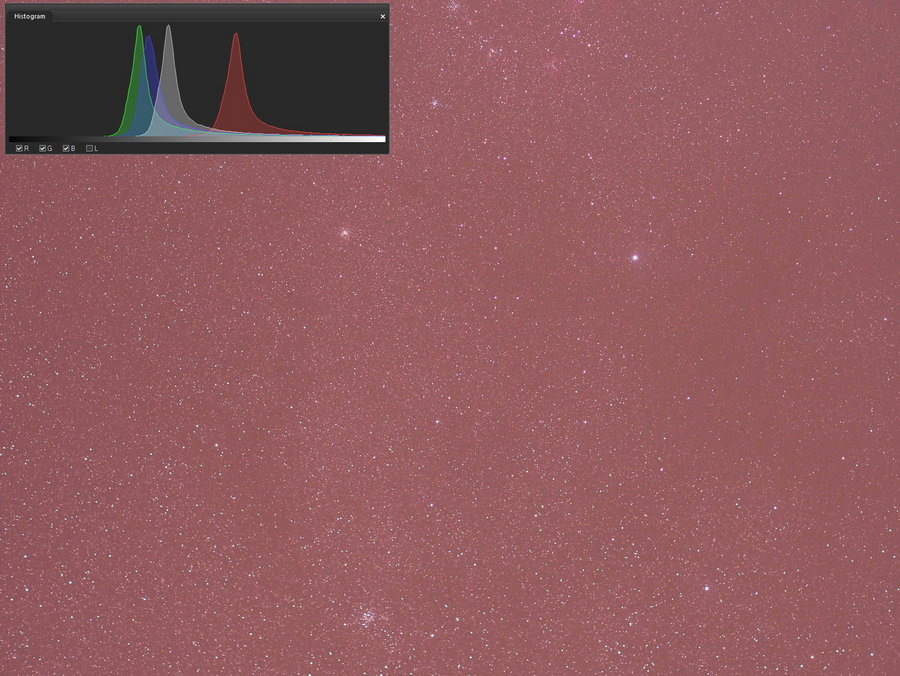

Am 1.1.2022 machte ich ein Experiment mit meinem "Dual narrowband" Filter: Dem Optolong L-eNhance 2019 hatte ich ja schon mal unter "Blog's" über Schmalbandfotografie ausführlich geschrieben Das L-eNhance ersetzte die damals beschrieben Kombination aus dem billigen visuellen UHC Filter und dem notwendigen UVIRCutfilter. Diese Spezialisierten Dual Narrow Bandfilter für die Fotografie, beschneiden ja dann auch den IR Bereich. Ich hab das L-eNhance mal im Fotometer ausgemessen: Die Kurven zeigen die Durchlässigkeit (Transmission) bei den jeweiligen Wellenlängen: Dunkelrot: Ist der L-eNhance Filter, der in dem Bereich öffnet wo der ionisierte Sauerstoff (500nm) und Wasserstoff (656nm) strahlt. Rot: Zeigt ein normales UVIRCut Filter, dass von 400-700nm öffnet. Der "normale" Filter, den man nimmt, wenn man eine modifizierte Kamera hat, die mit Klarglas Modifiziert wurde. Leider gibt es bislang für Olympuskameras keine passenden Filtermodifikation, die gleich ein UVIRCut Filter Glas verwenden. Das ist insofern schlecht, dass man hier für große Fotooptiken auch immer ein großes Filter finden muss, dass auch sehr gut ist und preislich noch im Rahmen bleibt, wie ich sie mit dem Haida UVIR750nm Filtern gefunden hatte. Preislich liegen die guten Schmalbandfilter in der 2" Größe über 200 Euro. Für große Fotolinsendurchmesser falls es sie gibt, also eher Unerschwinglich! Da wäre ein Clip In Filter vor dem Sensor das Mittel der Wahl, gibt es bislang nur von einem Hersteller (STC), aber die produzieren meiner Meinung nach zu viele Reflexionen bei hellen Sternen. Es besteht auch eine weiteres Problem der Interferenz filter vor einem Objektiv: Das Licht muss möglichst senkrecht durchfallen. Also ein 2" Filter vor einem 12mm gibt alles an möglichen Farbnuancen. Solche Filter gehören vor dem Sensor und natürlich auch ohne jegliche Verkippung. Ich experimentiere (halbherzig) mit einem Filterhalter aus dem 3D Drucker für 1,25" Filter. Die würden sich nämlich auch vor dem Filter ausgehen. Ungelöst aber: Verkippungsgefahr der Filter und wie bekommt man das mit dem Wechsel einfach hin. Auch das wäre eine Baustelle, die OM Systems einfach lösen könnte, wenn sie wollten. Egal! Für die Standard 2" Astrofilter habe ich mir schon zu Beginn einen Adapter von 52mm Gewinde von Objektiven, auf 2" Filter anfertigen lassen. Für die kleineren Linsenfilterdurchmessern habe ich step-up Ringe. Step-down für größere Linsen reduzieren die Öffnung und damit das Licht. Unsere Optiken sind auch ohne Aperturbremsen gut genug 😉 Mein verfügbares Objektiv mit der längsten Brennweite und das maximal einen 2" Filter erlaubt, ist das Olympus mFT45/1.8. Gerade bemerkt: Das 60er Macro würde auch gehen, ist aber lichtschwächer. Mir fällt spontan ein Objekt ein, dass groß genug für das 45mm Objektiv ist und gerade hoch über den Himmel zieht: Der Spaghetti Nebel (Simeis 147, SH2-240) im Sternbild Stier. Der Überrest einer Supernovae Explosion vor ca. 40.000 Jahren. Er ist 3000 Lichtjahre weit weg und mit einen Durchmesser von mittlerweile 140 Lichtjahren nimmt er 3 Grad am Himmel ein. Damit ist er also gut 6x so groß wie der Mond mit seinen 0,5 Grad am Himmel. Der Sternenrest selbst blieb als schnell drehender Neutronenstern, einem Pulsar zurück. Zum Inneren hin verblasst der Nebel immer mehr und mit den Überresten werden viele schwere Elemente in die Umgebung verteilt. Sie bildet den Grundstoff für Entstehung von Planeten und vielleicht auch Leben Ich packte also die Kamera auf den StarAdventurer und stellte alles möglichst weit hinten im Garten auf, um dem hellen weißen Licht der nachbarlichen Weihnachtsdekor zu entgehen. Mit dem Schmalbandfilter sieht man zunächst mal nichts auf dem Display. Die E-PL6 hat ja nur LiveView Ext. I. So schraubte ich zunächst den Filter ab und fokussierte mal. Danach am hellen Stern ß-Tauri (der obere Hornstern des Stier) dann ist darunter mein Objekt. Nach Aufschrauben des Filters fokussierte ich erneut am Stern, den man jetzt auf jeden Fall sieht. Was einem da jetzt sofort auffällt: entweder ist es der Rote Teil (h-alpha scharf), dann ist der Rest des Sternes groß und unscharf. Man sieht einfach, dass Linsen so gut sie auch gerechnet sind, nicht 100% farbrein sind. Bei s/w Kameras ist das auch kein Problem, weil jeden einzelnen Filter scharf gestellt wird und Spiegelteleskope sind von sich aus farbrein. Man hat hier im blau/grünen Bereich (O-III) ja 500nm und H-Alpha zu 100% bei 656nm zur Verfügung. Bei normalen Kameras beginnt der Filter vorm Chip bereits, ab 550nm zu sperren und sinkt weiter ab bis er bei 656nm nur noch 1/3 durchlässt. Daher sieht man hier die Farbtrennung der Optiken nicht so gut. Ein Abblenden würde es natürlich auch besser machen, aber das bedingt wesentlich längere Belichtungszeiten. Ich wollte mich auf 1 Minute beschränken, weil das bequem der interne Serienbildmodus erlaubt. Blende hatte ich auf F/2,5 und ISO auf 1600 gestellt. So werkelte die Kamera vor sich hin, als ich dann mal mit Licht kontrollierte stellte ich nach einer Stunde fest: Der Filter war in der Mitte zugetaut. Nachher bei genauer Kontrolle: Es hat bereits nach 24 Minuten begonnen. Man konnte es am immer heller werdenden Hof um ß-Tauri gut erkennen und dass im Zentrum immer mehr schwache Sterne verschwanden. Hier also ein Screenshot eines der Bilder mit den L-eNhance Filter (Bildvorschau in ACDSee und einmal mit automatischer Streckung und Farbkorrketur. OOC: Automatische Streckung+Weißabgleich Oben das Histogramm eingeblendet. Wie üblich: Die üblichen Automatiken der Kamera kommen mit dem vielen Rot nicht zurecht, dem Weißabgleich fehlt jede Menge Grün. Der versucht so gut es geht die Histogrammpuckel von Rot/Blau mit Grün zu vereinigen. Dafür kommen dann schon mal die starken H-alpha Emmissionsnebel heraus. S147 ist der große Bereich links unterhalb des hellen Stern rechts oberhalb der Bildmitte, ß Tau, oberhalb sieht man Teile des "Flaming Star" Nebel im Fuhrmann. Wer genau hinsieht: Beim hellen Stern unten rechts (der untere "Hornstern" des Stier) ist oberhalb leicht rechts der Krebsnebel (M1) zu sehen. So tauschte ich dann den Filter dann gegen einen UVIRCut Filter, um Material für die Sternenfarben und guten Hintergrund zu bekommen. Ich erinnerte mich an meine Neuwerwerbung im Dezember: Den "Ecoflow River 600" Portable Power Station, die ja bis 2000 W liefern sollte. Kam recht für einen Test: Also Föhn angesteckt und mal zwischendurch auf den Filter geblasen. Nach 27 Bildern war dann sowieso Schluss, weil es zuzog. Hier ein OOC (out of Camera) Bild mit dem Histogramm: Ein typische Anmutung eines Bildes, wenn man eine modifizierte Kamera einsetzt. Rot dominant wegen der Modifikation, Grün und Blau daher schwächer. Dass etwas mit der Lichtverschmutzung nicht stimmt, kann man am starken Blauen Kanal sehen: Das kommt von den LED Beleuchtungen. Blaues Licht wird ja stark gestreut am Himmel, ist also üblicherweise immer schwächer als Grün. Daher ist es so schwierig, das schwache Leuchten des Sauerstoffs abzubilden. Da ist üblicherweise sehr viel weniger als Wasserstoff und es wird eben stark gestreut. Visuell ist es aber in einem Bereich wo wir gut sehen können, denn H.alpha sehen wir praktisch nicht mehr. Am S147 ist zwar auch O-III zu finden, aber da etwas mit der kleinen Optik bei dieser blauen Lichtverschmutzung zu sehen, halte ich hier für illusorisch. Am Ende machte ich noch Flats (mit den jeweiligen Filtern) und dann BIAS und Darks. Wichtig bei den Flats jedenfalls: Nicht die Schärfe verstellen und Blende sowieso! Belichten wie üblich mit +1eV (Blende). Dann stackte ich die Bilder: Natürlich interessierte mich gleich mal, ob ich S147 überhaupt sehen konnte: Ein Screenshot aus PixInsight nachträglich arrangiert: Links oben: Der Stack der Schmalband Bilder (Hintergrundextraktion + Automatische Streckung und Weißabgleich). Natürlich kommt dieses Programm besser mit Weißabgleichen zurecht, als es die eingebaute Software der Kameras, die auf Tageslicht getrimmt ist und dem verbauten Filter dass einen Hauptaugenmerk auf grün und blauer legt. Wenn man weiß wo man suchen muss, sieht man das Objekt als schwachen roten Bereich links des Sterns ß-TAU. Rechts daneben das selbe Bild, aber ohne Sterne. Da gibt es mittlerweile Programme, die auf ein Neuronales Netzwerk zurückgreifen, wie StarNet++ oder StarXterminator. Da sieht man die "Kugel" schon besser. Daraus kann man jetzt Masken machen und herumspielen um den Nebel extrem hervorzuheben und letztlich wird dann das Bild in das Sternenbild eingemischt. War mein erster Versuch so etwas zu machen, natürlich war das alles nicht optimal, hier eher aber mit brachialer Gewalt gemacht 😉 denn ich habe hier einfach den Roten h-alpha Kanal eingemischt. Mittlerweile gibt es hier auch gute Scripte: NBRGB (narrow band RGB combination): Also kein stupides addieren von Schmalband zum RGB Bild. Sondern es wird vorher der Schmalband Anteil vom RGB Spektrum abgezogen und nachher erst addiert. Auch hier eine Verbesserung, um zu "richtigeren Bildern" zu kommen. Sofern man bei Astrofotos überhaupt davon sprechen kann, denn die Helligkeitswerte zueinander stimmen ja in keiner Weise. Wenigstens die "Farben" sollten stimmen, wenn man davon absieht, dass wir H-alpha an sich auch kaum mehr selbst sehen können. Egal 2 😉 Man muss jetzt bedenken, dass hier gerade Bilder mit unter 1 Stunde Gesamtbelichtungszeit verwendet wurden für Schmalband. Normalerweise wird man ein solches Objekt mit mit gekühlten hoch empfindlichen s/w Kameras machen. Und meist mehr als 15 Stunden. Auf analogen Filmen waren damals nur ein paar der hellsten Bereiche zu finden.... Siegfried -

methodik Unfertiges vom 1.1.2022

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

Am Neujahrstag war es tatsächlich relativ klar (für den Winter) und die Temperaturen sanken zuletzt gegen 3 Grad und es wurde schnell feucht. Da die Vorhersage nur eine kurze Zeit auf klareren Himmel voraussagte und die Wolkenbilder auch nicht so eindeutig war, entschied ich mich für das "kleine Setup" mit Fotolinsen. Einmal eine Versuch an einem extrem schwachen Objekt (Spaghetti Nebel) mit dem mFT45, mehr dazu ein andermal, und eben einmal mit dem Samyang 135. Da blieb dann die große Montierung zur Nachführung. Dafür keinerlei sorgen über die Güte der Nachführung 😉 Letztens hat unser Nachbar Weihnachtsbeleuchtung am Balkon installiert - der Gau für mich ! Zerstört er duch die wenigen seltenen klaren Mondlosen Nächte im Winter. Ein Gutes hat die Sachen: Es ist problemlos möglich das Setup ohne zusätzliche Lichtquellen zu fotografieren: Das verhinderte natürlich tiefe Bilder während einer der seltenen dunklen Winternächte. Man sieht auch auf diesem Bild bereits links die Sternbilder des Frühlings: Das große Sternbild des Löwen und ca. Bildmitte oben M44 (Presepe) umrahmt von 4 Sternen, das Sternbild Krebs. Leider kann man ja heute mit LED fast ohne Kosten extrem viel Licht machen. Und noch dazu in einem Farbenmix, der die schwachen Farben der Nebel überdeckt. Oranges Licht könnte man ja noch etwas wegfiltrieren, aber weißer LED Lichtmix überstrahlt die meisten Wellenlängen der Objekte. Egal,Ein bisserl was geht immer 😉 Und in Übung bleiben ist notwendig. Das war das Objekt für mein 135mm Teleobjektiv: Der Gürtel des Orion: Da ist ja unter dem hellen Stern Alnitak (der linke) der Pferdekopfnebel und daneben der Flammen Nebel. Und das Feld habe ich so gewählt, dass M78, "Kasper der freundliche Geist" eine heller Reflektionsnebel, wo heiße junge Sterne den Rest der Nebel beleuchten. Der hellste Stern am Himmel - Sirius (S) steht genau Mitternacht im Süden. R = Rigel B = Beteigeuze Der Stern, der sich letztes Jahr so stark abdunkelte. So sieht also ein Einzelbild aus - direkt aus dem Fotoapparat. M78 ist der Reflexionsnebel - in den Staubwolken bilden sich gerade Sterne und die heißen jungen strahlen da heraus und man sieht teile des Restlichen Nebel. Der Flammen Nebel gleich beim hellen Alnitak und unterhalb der leuchtende Bereich mit der Dunkelwolke Inform eines Pferdekopf. Weniger anzeigen Ausgearbeitet Weiter ausgearbeitet habe ich die Bilder noch nicht... Das Feld hatte ich mir vorher mit Stellarium geplant. Man braucht da ja nur Kamera und Objektivdaten eintragen und dann sieht man, was so auf Bild passt. Siegfried- 2 Antworten

-

- 4

-

-

-

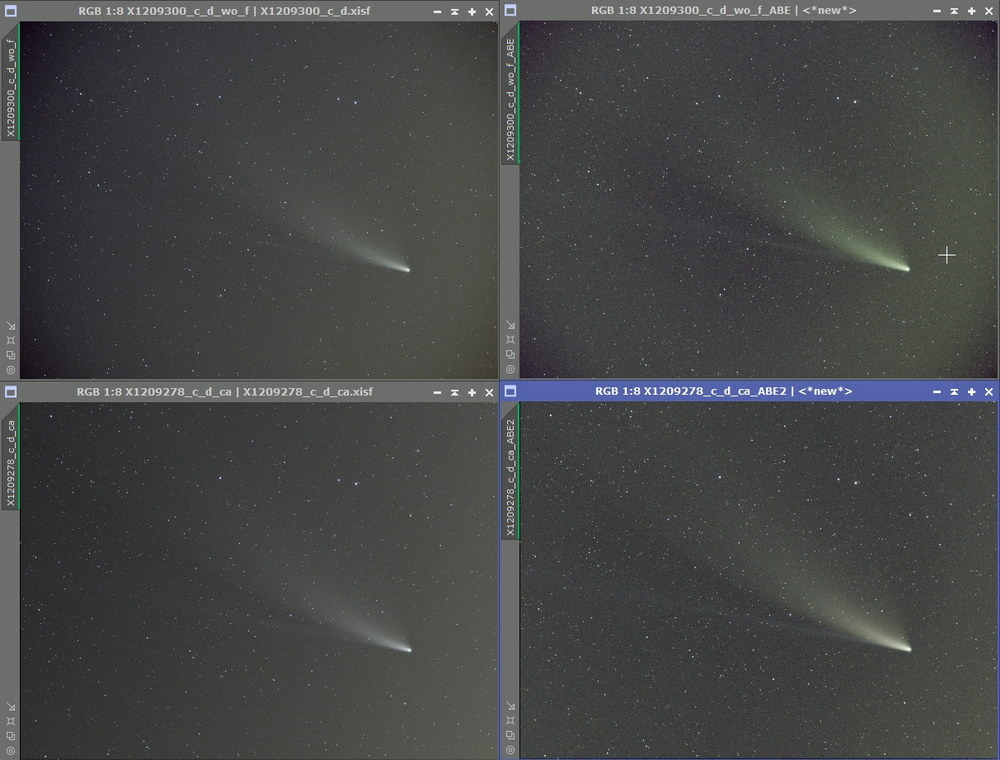

methodik Kometen fotografieren

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

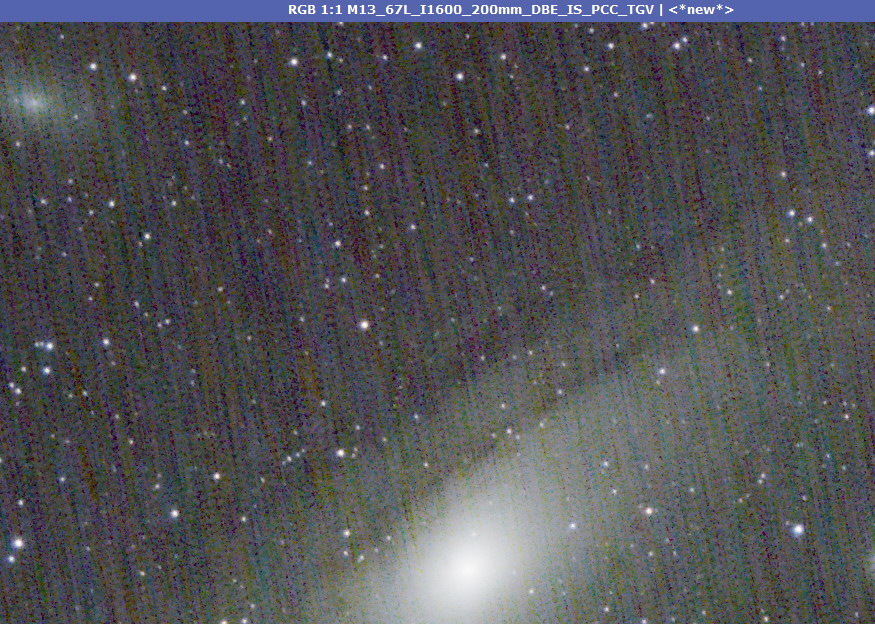

Kometen fotografieren Vielleicht ergibt sich ja noch schnell die Gelegenheit mal einen helleren Kometen zu fotografieren. Und wenn nicht, der nächste kommt bestimmt 😉 Zunächst müssen wir sie mal finden: Es braucht jedenfalls Vorbereitung um die Suche einzugrenzen. Im Stellarium kann man sich im Modul Sonnensystem Editor aktuelle Bahndaten hereinholen und wenn man bei „Teleskopen“ seine Brennweiten und Sensoren hinterlegt hat, auch einfach das Bildfeld der jeweiligen Optiken simulieren. Mit LiveView Ext. II kann man Teile des Kometen dann vielleicht schon im Display sehen, wenn man mal weiß wo er steht 😉 Ein Fernglas zur Suche ist sicher sehr hilfreich, aber auch Fotos machen und sie bei höchster Vergrößerung durchsuchen… hilfreich wenn helle Sterne / Planeten in der Umgebung. An sich ist es zunächst nicht schwieriger, als normale „Deep Sky“ Fotografie. Was allerdings die Sache schwieriger gestaltet: Je näher sie uns sind, desto schneller bewegen sie sich vor dem Hintergrund, was die zur Verfügung stehende Belichtungszeit schon stark reduziert. Kometen verhalten sich mitunter recht dynamisch, so wie das Flackern einer Kerze. Und sie können uns auch mit Helligkeitsausbrüchen (leider auch Einbrüchen) überraschen. In Sonnennähe kommt es immer wieder zu Abspaltungen von Trümmern. Das geht auch bis zu einer Auflösung oder Ausbrennen in Sonnennähe. Diese Dynamik dann auch noch in Animationen zu zeigen, ist aber eher für absolute Kometenprofis. Wir sind ja schon froh ein tolles Bild zu bekommen. Daher braucht es eine lichtstarke Optik um die Belichtungszeit auf 10-30 Sekunden beschränken zu können. Wie lang genau, muss man sich ansehen und ist abhängig was wir tolerieren wollen. Gerade der helle Kern wird ja schnell deutlich in die Länge gezogen. ISO1600 ist hier sicher kein Fehler und problemlos möglich um genügend Signal zu haben. Kontrolle am Histogramm Der Peak sollte 30-50% von links stehen. Wenn sie hell sind und einen schönen Schweif ausbilden sind sie auch recht groß. Ein vielfaches des Mond wie er uns am Himmel erscheint. Daher braucht es dann auch keine langen Brennweiten, was uns insgesamt das Nachführen wesentlich erleichtert. Wer keine hat, kann es auch vom Stativ versuchen, aber dann eher nur mit starkem Weitwinkel und wird die Belichtungen eher unter 10 Sekunden halten müssen. Das sehe ich dann auch eher ISO3200, vielleicht auch 6400?. Profis nehmen vielfach natürlich hochempfindliche gekühle s/w Kameras mit Filtern was die Sache um viele Aspekte aufwändiger gestaltet. Mit einer „normalen“ Farbkamera ist man da aber insofern oft besser gestellt, dass man z.b. das orange Natriumleuchten auf den Bildern finden kann. Dieses Licht wird bei Filter gegen Lichtverschmutzung und R/G/B Filteren stark ausgeblendet. Was wir jedenfalls brauchen: Am besten 20-40 Bilder, was das Signal/Rauschverhältnis ja stark verbessert, business as usual 😉. Die letzten hellen Kometen waren bei uns oft in Horizontnähe, und entweder kurz vor Sonnenaufgang oder Untergang. Das stellt schon sehr hohe Anforderungen an den Himmel, der auch da noch möglichst klar sein muss. Zur Planung der Belichtungen muss man auch beachten, dass man eine Serie mit gleichmäßigen Abständen hat. Also die Zeitabstände zwischen den Belichtungen gleich halten. Ansonsten kann es je nach Methode der Ausarbeitung zu unschönen Mustern kommen. Lange Rede kurzer Sinn: Man muss es einmal mehr schaffen: Einige gute gelichtete Bilder zu bekommen, deren Zeitabstände auch gleich sind. Die nachträgliche Bearbeitung geht von relativ einfach bis sehr schwer. Der einfachste Weg wird ein Stack wie üblich auf die Sterne sein. Das führt aber zu einem verwischen des Kometen. Der bessere Weg ist hier, dass man auf den Kometen selbst stackt. Da gibt es z.b.: beim Deep Sky Stacker eine eigene Funktion dazu. Man muss vorher dem Stacker dann natürlich helfen und zumindest im ersten und letzten Bild den Kern des Kometen markieren. Die Werte dazwischen werden interpoliert, weshalb es dann eben Bilder mit den selbe zeitliche Unterschieden braucht. Man erhält so recht schnell ein Bild, wo der Komet eben dann still steht und die Sterne mehr oder weniger Striche oder Punktspuren bilden. Schon wesentlich schwieriger ist es aber zu einem Bild zu kommen, dass den Kometen vor dem Sternen zeigt. Zumindest die Theorie dazu ist einfach: Man stackt auf die Sterne. Dazu sind die „rejection“ Parameter so eingestellt, dass der Komet, der da ja durchs Bild zieht herausgerechnet wird. Und man stackt auf den Komenten und die Sterne die jetzt durchs Bildfeld ziehen werden herausgerechnet. In der Praxis bleiben da leider immer Sterne bezw. Teile des Kometen über. Daher ist eine aufwendige Bearbeitung zur Bereinigung dieser Spuren angesagt. Schwierig auch schwache Sterne hinter dem Schweif und helle Sterne in der Nähe des hellen Kometenkerns, der Coma. Rejection Algoritmen arbeiten auch besser, wenn man längere Zeitabstände zwischen den einzelnen Bildern hat. Denn damit wird besser erkannt was nur einmal an der selben Stelle im Bild ist und damit verworfen werden kann. Trennt man den Kometen von den Sternen wird man bald ein weiteres Problem bemerken: Wie macht man den Farbabgleich im „nur Komet“ Bild? Beim Sternen Bild gibt es ja einiges an Vorgangsweise. Man sollte also einen Weg suchen, wie man die Parameter des Farbabgleiches dann auf das gleich bearbeitete Kometen Bild überträgt. Klar: Schummeln durch verdrehen der Farbmischer geht immer, aber wäre es nicht besser, ein möglichst richtiges Bild auch was Farben betrifft (wenn auch wie immer stark verstärkt) zeigen zu können? Dem Problem, wie man möglichst Artefaktfreie „nur Sterne“ und „nur Kometenbild“ Stacks bekommt, tragen einige Workflows Rechnung. Man versucht dann z.b. das Sternen Bild in einem weiteren Stack schon beim Stacken aktiv vom dem des Kometen abzuziehen. Hinterher vereinigt man dann das Sternenbild mit dem Kometenbild. Kann man das in einem früheren Stadium des Workflows machen, hat man es natürlich einfacher mit dem Farbabgleich. Allerdings ist es einfacher, ein „nur Sterne“ und einen „nur Kometen“ Stack mal getrennt vorher nach allen Regeln der Kunst zu verfeinern. Mittlerweile gibt es ja auch zwei Sternentfernungsprogramme die auf ein trainiertes neuronales Netzwerk zurückgreifen: Das kostenfreie StarNet++ und der neue kostenpflichtige StarXterminator (30 Tage Testversion). Das ermöglicht uns jetzt auch eine Sternentfernung schon sehr früh im Workflow und damit möglicherweise effektiver. StarNet++ arbeitet allerdings praktikabel nur am gestreckten Bild. Also wäre es einen Versuch wert, es in einem Photoshop ähnlichen Workflow einzusetzen. StarXterminator funktioniert auch an linearen Daten (RAW). Man würde dann versuchen auf den kalibrierten jeweiligen Einzelbildern schon eine Sternentfernung durchzuführen. Da man da dann schon üblicherweise in PI (PixInsight) arbeitet,das ja schier unendlich viele Möglichkeiten bietet, kann man jetzt die alten zurechtgelegten hergebrachten Workflows erweitern oder verlassen: Bei den einzelnen kalibrierte Bilder bereits Sterne entfernen und Lokale Normalisierungen und GradientenScaleNormalisierungen durchführen (gerade in Horizontnähe nötig). Umgekehrt kann man dann auch gleich für die Bilder des „Sternen Stacks“ den Kometen vorab herausrechen. Danach erst den hoffentlich möglichst „reinen“ Kometen stacken. Und auf Sterne sowieso… Ok, zuletzt Geschriebene könnte wohl mehr verwirren, weil es tiefe Kenntnisse und Erfahrungen voraussetzt, die man aber im Laufe der Zeit sammelt. Für alle und immer wichtig: Kalibriert Eure Bilder sorgfältig: Also Darks und Fllat/BIAS (bezw. FlatDarks). Das ergibt das bestmögliche Ausgangsmaterial, denn der Rest ist schwer genug! Flats/BIAS (oderFlatDarks) lassen sich bei Fotooptiken ja leicht auch später schnell machen. Ist meist keine Hexerei! Und einmal mehr: Die Kunst ist es, sich an dem zu Erfreuen, was man selbst hervorbringt und nicht an dem zu Verzweifeln was Profis zeigen oder so Manche hinzufaken versuchen. Siegfried BTW: Das Bild zeigt einen Screenshot beim Ausarbeiten bei meinen Versuche letzten Jahr am C/2020 F3 Neowise…. -

praxis Mal etwas aus der Praxis am M13

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

Außer bei sehr hellen Objekten wie die Sonnensystemkörper wo man notfalls ein bestimmtes Ereignis festhalten will, ist klarer und möglichst dunkler Himmel eine der wichtigsten Grundvoraussetzung. Zwischen den Schlechtwetterperioden Ende Mai bot sich eine kurze Gelegenheit um die ohnehin kurze astronomische Dunkelheit. Bei mir war das damals, 3 Wochen vor Tag/Nachtgleiche erst kurz nach 23:40. Der noch sehr helle Mond gesellt sich dann auch gegen 1:00 dazu, was hier sowieso zu einem Abbruch führen würde. Durch die feuchtere Luft und starke Abkühlung (Ende Mai bis auf 4 Grad morgens) konnte man schon ahnen, dass es wenn überhaupt nicht lange klar bleiben würde. Denn es bilden sich dann bald in größeren Höhen Dunstbänke oder gar Wolken, die den Himmel durch reflektiertes Licht der noch immer stark zunehmenden Lichtverschmutzung stärker aufhellen. Bei solchen Objekten wie Sternhaufen aber nicht so das Problem. Sterne sind ja recht hell. Ein Test mit dem Himmelsqualitätsmesser (SQM-L) hatte ich dann tatsächlich bald mal Werte um 20,70 später sogar gegen 21 gemessen, bis es dann merklich aufhellte gegen 01:10 durch Dunst und aufgehenden Mond. Rein visuell merkt man diese Verdoppelung der Helligkeit am Himmel kaum. Nur im Histogramm wandert der Peak (der Himmelshintergrund) leicht. Durch Dunst verbreitert sich dann irgendwann mal auch der Peak, weil das helle Sternenlicht zu Halos um die Sterne führt. Das kann natürlich auch eine beschlagene Linse sein, aber das war hier gerade nicht mehr das Problem, es war knapp davor und gerade noch klar für das Anfertigen der Flats. Egal aus den mehr als 2 Stunden konnten ich nach visuellem Aussortieren aller schlechten Bilder (durchziehende Wolkenbänke und diffuse Eintrübungen durch hohe Nebelbänke) 21 Bilder bekommen für die Bearbeitung. Damit kann man dann schon was anfangen und für diesen Zweck reicht es. Ich notiere mir immer wieder ein paar Eckdaten zu der Session: --------------------- Samstag immer wieder Wolken AZ-EQ6GT + E-M1.III mFT100-400 @400 F/6 2min ISO1600 24L 8D 58FD 34B 60F 23:25 8/82% SQM 20,70 23:45 8/84% SQM 20,70 00:15 7/86% SQM 20,90 00:40 7/88% SQM 20,68 Dunst! Abbruch Drüb hell !! Mond bereits aufgegangen F/D/FD/B ISO200 +1eV -------------------------- Neben der Qualität des Nachthimmels gibt es einen zweiten unabdingbaren Punkt: Wir brauchen scharfe genügend lang belichtete Bilder. Scharfzustellen vor allem bei länger brennweitigen Objektiven geht u.a. mit einer Bahtinov Maske, aber auch bei hoher Vergrößerung rein Visuell an einem helleren Stern recht gut. Die E-M1.III kann hier auch den Sternen AF Modus, der aber bei lichtschwachen Objektiven und langen Brennweiten auch bald mal versagt bezw. auch kein besseres Ergebnis bietet, als visuell die Größe des Sterns beim manuellen fokussieren zu beobachten. Das grundlegende Problem ist aber nun mal: Man muß oft minutenlang belichten. Das kann man mit wenig Aufwand und einem gutem Tracker bei kleinen Brennweiten (<70mm) noch hinbekommen. Noch dazu sind kleine Lichtstarke Brennweiten noch vergleichsweise günstig. Größere Brennweiten brauchen dann eine nochmals stark gesteigerte Nachführgenauigkeit und weil sie naturgemäß auch lichtschwächer sind zusätzlich noch längere Belichtungszeit. Da wird es mit den Freiheiten der Fotografie schnell sehr eng. Man liest ja oft, StarAdventurer (wohl einer der Besten günstigen) von bis zu 400mm kein Problem, aber man darf hier nicht vergessen: Wir haben FT Sensoren wo 400mm eine Vergrößerung eines 800mm an einem KB Sensor sind. Diese KB Sensoren haben noch dazu größere Pixel, die mehr verzeien. Also 200mm bei 4 Minuten an einem StarAdventurer würde ich schon als sportlich bezeichnen, wo sich einer wirklich mit der präzisen Einnordung gespielt hat und man das Glück hatte, dass gerade alles so läuft wie es sollte. Das tut es nämlich oft nicht, was man aber in der eigenen Praxis bald herausfindet. Dazu kommt aber auch: Auch wenn die Sterne rund aussehen mögen aber über längere Zeit sich das Bildfeld in eine Richtung verschiebt, kommt es dann zu einem sehr eunschönen, praktisch nicht zu korrierenden Effekt der "wandelnden Schatten" besser als walking shades oder moving noise. Dem kann man entgegensteueren indem man ab und an sein Bildfeld etwas versetzt. Nennt sich dithering. Da ich über eine sehr gute Montierung verfüge und ich zu einem Ergebnis kommen will, habe ich es hier leichter: Einfach das Ganze auf die große GoTo Montierung (SkyWatcher AZ-EQ6) und damit auch die Nachführung absolut präzise läuft mit Guiding. Mittlerweile brauche ich (wenn alles läuft wie es soll) unter 30 Minuten bis alles von alleine meine Belichtungen sammelt..... Der letzte wichtige Punk, den ich hier aber jetzt nicht bespreche: Die nachfolgende Bildbearbeitung. Da kann man auch mit noch soviel Geld keine Software kaufen, die einem das abnimmt. Da ist hart erarbeitetes eigenes Gewusst wie gefordert. Unsere Oly Kameras und verfügbaren guten Linsen sind hier jedenfalls die längste Zeit nicht der limitierende Faktor. Jetzt also zu dieser Session: Vorher habe ich mal bei MeteoBlue die Seeingprognose geschaut, wie die Bedingungen für meinen Raum vorhergesagt sind und beim lokalen Wetterdienst (INCA Karte) den Bewölkungsverlauf studiert um zu entscheiden probieren oder lieber schlafen 😉 Für alles andere wäre die Nacht sowieso zu kurz und schlecht, so entschied ich mich spontan für M13 mit dem 100-400 Zoom. Also das Ganze aufgebaut und mit der schnellen Kochab Methode eingenordet: Mit einem Auge durch das Polsucherfernrohr geschaut und mit dem anderen Auge die Position von Kochab (2. hellster Stern im Kasten des kleinen Wagen/Bären) und dann den Polarstern an die Position im Ring des Polarscope gebracht dass er auf einer Linie vom Zentrum aus zu Kochab steht. Das ist genau genug, dass ich bei 800mm zwischen 40 Sekunden und 1min 20 belichten könnte. Mehr Präzision erfordert dann einfach wesentlich mehr Zeit zum Einnorden. Aber das erspare ich mir, weil ich ja mit einem Stern guide. Damit wird eine Abweichung von soll präzise laufend korrigiert. Danach ein 1-Stern Alignment an der Wega gemacht: Das Teleskop fährt dabei von der Startposition (auf Norden ausgerichtet) in die Nähe des Sterns. Wenn man Glück hat, sieht man den Stern im Sucherfernrohr. Dahin muss man ihn mit der Motorsteuerung der Handbox (oder was auch immer man verwendet) bringen.Und zwar mittig ins Fadenkreuz. Hat man bei den vorherigen Sessions schon mal alles so abgeglichen dass der Stern dann auch in der Mitte des Bildfeldes der Kamera steht bestätigt man die Position. Wenn nicht: Stern in der Mitte des Kameradisplays und bei der Gelegenheit das Fadenkreuz des Sucherfernrohr so einstellen, dass der Stern auch in der Mitte steht. Unseren Alignment Stern nehmen wir dann gleich um gut scharf zu stellen. Nicht vergessen: Fokus auf manuell lassen und bei der Kamera sollte die Linsenrückstellung deaktiviert sein. So bleibt der Fokus erhalten, sollte man mal einfach die Kamera abschalten wollen. Danach lasse ich mein Objekt anfahren. Wer eine Kamera mit LiveView Ext II hat, sieht M13 im Display. Er ist ja eingerahmt von zwei Sternen in ca 90 Grad Winkel zueinander. Hier könnte man dann natürlich noch sein Bildfeld korrigieren. Wer nichts sieht (hier aber sieht man zumindest 2-3 schwache Sterne auch ohne Restlichtverstärkung) macht ein Probebild bei hoher ISO und 10-15 Sekunden. Jetzt ist der Zeitpunkt, das Sucherfernrohr gegen eines mit dem Kamerakopf für den Guider zu tauschen. Ich habe da zwei (sind ja günstig) und man erspart sich sehr viel Ärger, wenn man da nicht Kamerakopf gegen Okular tauschen muß. Danach alles verkabeln: Bei meinem MGen Autoguider: Ein Kabel (Batchkabel) geht an den Kamerakopf, der durch das Sucherfernrohr auf einen Stern im Bildfeld schaut. Ein Kabel (ST4) geht an die Montierung und korrigiert Nachführungsfehler. Dann gibt es natürlich ein Stromkabel dass an eine 12V Quelle (Batterie oder stabilisiertes Netzteil) geht. Und ein Kabel für den Fernauslöser zur Kamera. Danach lässt man am Guider einen Stern suchen und startet eine Eichung. Dabei bewegt er die Montierung, wertet das aus um danach zu wissen, wie stark das Korrektursignal sein muss, damit der Stern bewegt wird. Das dauert keine Minute. Danach ist alles Fertig zur Belichtung: Die Kamera ist hier auf LiveTime 2 Minuten gestellt, ISO ist richtig, Antiwackel ist aus und die Auslöseverzögerung auf meine üblichen 4 Sekunden gestellt. An der Belichtungssteuerung des Guiders sind dann 2 Minuten und ca. 10 Sekunden eingestellt. Die Kamera braucht ja etwas zum Speichern auch noch und die 4 Sekunden Auslöseverzögerung. Besser auf der sicheren Seite - vor allem wenn man 2 Kameras auslösen will, die unterschiedlich schnell sind beim Speicher. Wenn dann das Guiding gestartet wird wird die Kamera ausgelöst und man kann dann im Display (bei mir alle 30 Sekunden ein refresh) zusehen, wie hier bequemer Weise das Bild sich aufbaut. Günstig auch: Die Kamera so einstellen, dass sie nach Speichern kurz das Histogram zeigt, zu schnellen Beurteilung. Da der Guider auch das dithering mache, wird dann das Bildfeld für die nächste Aufnahme leicht versetzt (schlangenförmige). Sobald dann alles stabil läuft wird die nächste Belichtung ausgelöst. Wer sich nicht sicher ist, kontrolliert nach dem ersten Bild an der Kamera nach ! Würde sich die Temperatur der Linse stark ändern sollte man zwischendurch mal erneut scharf stellen. Wer eine präzise Montierung hat mit GoTo, hat es hier relativ leicht: Einfach wieder einen hellen Stern fürs Scharfstellen anfahren und danach das Objekt wiederfinden und weiter belichten. Ihr könnt vielleicht heraushören: Wiederfinden! Hier ja kein Problem, aber es gibt Himmelsgegenden, da sieht man nichts am Display. Wenn man Glück hat mit starker Restlichtverstärkung vielleicht einen Stern, vielleicht hat man den Luxus sogar ein charakteristisches Sternenmuster zu erkennen, anhand dessen man sein Bildfeld möglichst genau wiederfindet. Sind die Aligmentsterne all zu weit vom Objekt entfernt, kann es aber sein, dass man das Objekt mit Probebelichtungen wiederfinden muß was ja noch geht, wenn man weiß wo man ist und da sein Objekt da auch sehen kann..... wenn nicht wird es mitunter Zeitraubend. Das sollte man bedenken, dass einem das ereilt wenn man immer wieder zwischendurch Scharfstellen muß. Also 15-20 Minuten belichten, neu scharfstellen und 5-? Minuten um sein Feld wiederfinden. Schon aus diesem Grund lege ich Kamera und Objektiv vorher schon zum Akklimatisieren hinaus. Zunächst offen damit im Body nicht auch noch feuchtere Luft aus dem Wohnraum im Gehäuse ist, die dann innen kondensiert. Und daher liebe ich meinen optimierten "Newton ohne Namen": Der Tubus ist aus Kohlefaser und der Spiegel aus Pyrex. Mit Ausnahme eines noch besseren Quarz Glas Spiegels, ändert sich nämlich dann auch der Spiegel. Das bei vielen billigen Teleskopen eingesetzte PK7 Glas ändert seine Form besonders stark. Spitz Zungen sprechen davon, dass er nie die Richtige Form hat. Natürlich muß der Okularauszug sehr gut sein, aber da merkt man auch schon mal wie fummelig es ist damit schon mal überhaupt Scharfstellen zu können. Ich hab es immer wieder bei meinem nachgeprüft: Der Fokus ändert sich die ganze Nacht nicht. Alle anderen Geräte haben eben das Problem der Fokusänderung wenn sich die Temperatur ändert. Bei Fernrohren für visuelle Beobachtung spielen solch Aspekte keine Rolle, wohl aber für Astrofotografie, wo sie darüber entscheiden ob man ohne graue Haare zu seinen Belichtungen kommt. Nach Abbruch sammle ich zunächst Flat Files: Dabei achten, dass die Schärfe nicht verändert wird und die selbe Blende verwendet werden muß. Da habe ich eine Flatfieldbox (die auch nicht flimmert!). Einfach mit +1eV (Blende) und schnellen Serienbild (silent shutter) 20-40 Bilder bei ISO200 sammeln. Danach merken wie lang die Belichtungszeit dafür war: Objektivdeckel drauf und mit der selben Zeit FlatDarks sammeln (geht ja schnell) und / oder BIAS Files: Einfach kürzest mögliche Belichtungszeit. Es geht aber auch nur mit BIAS oder FlatDarks, je nachdem, was Eure Stackingsoftware kann/braucht. Danach nicht vergessen: ISO wieder auf den Wert setzen mit dem man Seine Lights gesammelt hat. Und dann Darks machen: Gleiche Temperatur / ISO und Zeit wie bei den Lights. Da ich ja in der Zwischenzeit alles abbaue, drücke ich da immer wieder den Auslöser. Wer eine Sequenzer hat, kann den natürlich auch anstecken um die Darks zu sammeln. Danach sichte ich die Files: Zunächst in Ordner für Lights, Darks, BIAS und FlatDarks. Die Lights werden visuell in der Vorschau auf Helligkeit geprüft. Zu heller Hintergrund sind dann während der Session ja Wolken oder Dunst, oder gar Tau. In der 1:1 Ansicht prüfe ich auf verwacklte Bilder oder sonstwelche Fehler wie unrunde Sterne. Die verbleibenden Bilder werden dann wie üblich mit den Darks/Flat/BIAS kalibriert und gestackt und dann final ausgearbeitet... Hier also das Beste Einzelbild ohne Bearbeitung nur verkleinert (OOC): Das fertig Ausgearbeitete Bild gibt es hier: Hier also ein Überblick der Aufnahmesituation für dieses Bild. (Einzelbild vom Stativ mit dem 8mm reicht ja locker). Oben rechts der helle Stern ist Arktur, der hellste Stern und leicht zu finden, wenn man der Deichsel des großen Wagens weiterfolgt. Links der Helle oben ist Wega. Am Weg dahin sieht man deutlich im 1/3 die Nördliche Krone (Corona Borealis) in der Mitte des Bogens ein heller Stern, der "Gem" der Krone. Im 2/3 zur Wega ist der Körper des Herkules aus 4 helleren Sternen. Hier ist aus obigem Bild der Ausschnitt. Da kann man dann sogar M13 erkennen und die 2 helleren Sterne dabei: Viel Spaß beim Aufsuchen des "großen Kugelsternhaufen im Herkules" ! Siegfried -

praxis Sonnenfotografie

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

Schon lange nicht mehr die Sonne fotografiert, aber eine Sonnenfinsternis, wenn auch nur sehr partiell bot halt wieder die Gelegenheit. Gleich vorweg für die Sonnenfotografie: Wenn Euch eure Augen oder Kamerasensoren lieb sind, verwendet nur die genau dafür geeigneten Filter. Auch wenn ein Medium für uns sehr dunkel erscheint, es ist nicht gesichert, dass es nicht Licht anderer Wellenlängen durchlässt und dann unser Auge oder Sensor grillen. Die Firma Baader bietet da auch eine spezielle Folie dafür an. Man kann sich damit auch eine für seine Optik geeigneten Filter basteln. Aber bitte stellt sicher, dass nicht ein Windstoß diesen von der Optik stoßen kann, die Auswirkungen wären fatal. Auch mit bloßen Auge in die Sonne zu sehen ist keine gute Idee und schadet! Daher immer eine Sonnenfinsternisbrille oder durch besagte Folie. Bei Teleobjektiven genügt die günstige Folie, für Linsenteleskope auch. Wer ambitioniert Sonnenfotografie / Beobachtung betreiben wird, gibt es da aber auch andere Hilfsmittel wie Herschelkeil und spezial „Energieschutzfilter“ was bei letzteren aber gleich sehr sehr teuer wird. Was man aber gleich vergessen kann: Hoch dichte Filter vor zuschrauben. Die können schnell man springen…. Auch Spiegelteleskope werden bei der weitergehenden Sonnenbeobachtung nicht eingesetzt. Da sind es eben kleine Linsenteleskope. Wer mehr als Weißlicht beobachten/fotografieren will wird mehr als 1000 Euro einplanen müssen, an sich wird es bei kleinen Sonnenteleskopen ab 3000 Euro interessant und bei etwas größeren geht es schnell Richtung 10.000 Euro. Also zu meiner „mini“ Sonnenfinsternis am 10.6.2021. Oben habe ich erwähnt: Lange nicht mehr gemacht: Auch wenn ich schon ab und an die Sonne fotografierte, es geht hier nichts über verinnerlichte Praxis. Am besten wäre es wie in der Fliegerei: Ein Checkliste zu verwenden. Damit man nichts vergisst. Es fing bereits damit an: Wo habe ich meinen Sonnenfilter für das Teleskop überhaupt liegen 😉 Nach etwas suchen dann doch gefunden. Eine Sonnenfinsternisbrille hatte ich griffbereit in einem der zwei Koffer wo all das Zeug für’s Teleskop gelagert ist. Zum Seeing: Wer mal Sonnenflecken fotografieren will: Morgens oder abends ist das Seeing (flimmern der Luft) am besten. Muß nicht sein, aber meist ist es so. Steht die Sonne hoch, wäre zwar die Luftschichte gering, aber das Seeing ist einfach sehr schlecht. Natürlich kann man sich den Zeitpunkt bei einer Sonnenfinsternis nicht aussuchen, man muss halt nehmen war man hat. Bei mir war das Maximum der Bedeckung gegen 12:40 und ca 30 Minuten Später war alles vorbei. Bei den 5%, die bei mir war, aber selbst bei 80% sieht man die Effekte dass es dunkler wird, sicher nicht, vielleicht etwas bei 95%. Nur wenn wirklich 100% der Sonne bedeckt sind, gibt es dieses unheimliche Spektakel einer totalen Sonnenfinsternis, das ist aber eine andere Geschichte….. Wohl aber visuell mit der Sonnenfinsternisbrille, ich hab es probiert: Ja da fehlt ein Zipferl 😉 Was man auch mit einplanen sollte (nebst Eigenschutz wie vielleicht Sonnencreme oder Kopfbedeckung) Etwas großes möglichst dunkles, mit dem ihr die Kamera bezw. das Display abdecken könnt: Sonst sieht man am Kameradisplay außer die Scheibe nicht wirklich etwas. Und immerhin muss man ja scharf stellen. Und scharfstellen fällt mir bei der Sonne, mit all den Umständen, viel schwerer als an Sternen. Wenn man Glück hat sind ein paar dicke fette Sonnenflecken sichtbar, an denen man fokussieren kann, ansonsten bleibt nur der Rand. Also vorher ein aktuelles Bild der Sonne suchen, dann sieht man, wo man nach den Sonnenflecken suchen sollte. Ich habe ja den Luxus, über eine gute Nachführung zu verfügen und ein 800mm Spiegelteleskop. Im Garten weiß ich auch mittlerweile gefühlsmäßig wie ich das ganze hinstelle, dass es in etwa eingenordet ist. Das hilft dann sehr, dass die Sonne dann nicht allzu schnell aus dem Bildfeld wandert. Bei der Belichtung verwendete ich den P Modus und machte eine Probebelichtung. Mit der +- Korrektur steuerte ich dann die gewünschte Belichtung. An sich ging +0,7 eV leicht, und der Histogramm ging bis ca 80% ins Helle. Sicher kein Problem bei Alltagsfotografie. Aber wie am Mond auch: Mit Bildern wo der hellste Wert nur so bei 66% liegt hat man einen besseren Kontrast und ich tu mir bei der Ausarbeitung leichter. Natürlich machte ich auch Bilder mit +0,3 und 0,7 eV, Aber letztlich wie angenommen, waren die Bilder mit +-0 Blenden Korrektur besser. Meiner Meinung nach ist das deshalb, weil der Sensor bez. Das., was dann in den File geschrieben wird, gerade im oberen Bereich nicht mehr linear arbeiten um ein Bild nicht gleich ausbrennen zu lassen und eben 13 Blenden Dynamik zu „erzeugen“ trotz 12 bit Sensor. Also ist das Bild im hellen Bereich nicht mehr so kontrastreich. Da wir bei der Sonnenfotografie ja nicht annähernd den vollen Dynamikumfang brauchen, spielt es auch keine Rolle. Ist das Bild zu dunkel, machen wir es einfach heller. Was uns aber hilft: möglichst guter Kontrast bei den ohnehin flauen Sonneflecken. Zur Belichtung: Steht kein Fernauslöser zur Verfügung, dann sollte auf jeden Fall wie immer eine Auslöseverzögerung eingestellt sein. Bei mir standardmäßig 4 Sekunden. Natürlich auch hier: Wenn man kann: Möglichst viele Bilder machen und das dann stacken. Da bei mir der Himmel um den Beginn und zum Maximum stark bewölkt war konnte ich nur auf eine Wolkenlücke hoffen. Nunja: Eine genügend lange braucht man natürlich um mal das Teleskop auszurichten und eine weiter Wolkenlück um Scharf stellen zu können. Auch so ein Problem, wo Geduld gefragt ist, und wie immer: Rechtzeitig Aufbauen hilft hier, vor allem wenn der Zeitpunkt vorgegeben ist. Damit ich dann mal wenigstens ein Bild habe, denn die Wolkenlücken waren nicht wirklich groß und meist auch nie ganz klar, machte ich auch Bilder als Wolken durchzogen: Dann war mal ca. 5 Minuten nach Maximum eine größere Wolkenlücke und mit schnellsten Serienbildmodus (Silent Shutter, 60 Bilder / Sekunde bei den E-M1.III und Fernauslöser konnte ich 300 Bilder sammeln. Natürlich ist eine wirklich schnelle UHS-II Karte auch Voraussetzung. Weitere 10-15 Minuten gaben die Wolken weitgehend die Sicht auf die Sonne frei, so daß ich weiterer Serienbelichtungen machen konnte. Wie üblich exportierte ich dann mal die Bilder in 48bit TIFF, was dann Autostakkert lesen kann. 4% der besten Bilder bezw. Ausschnitte, mit 1,5x drizzle verrechnet: Das Ergebnis nachbearbeitet wie beim Mond: Schärfen, Kontraste erhöhen, selektiv bei den Sonnenflecken. Und die Sonne, welche Farbe sie am eigenen Bild auch hat, ist nun mal weiß und etwas fad wie ich finde. So färbe ich sie dann auf eine Farbe die mir mehr gefällt: Bei der Sonne eben gelb. Siegfried -

methodik Dunkelbild

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

Rauschminderung / Rauschfilter ? Mit Rauschminderung bezeichnet Olympus den Dunkelbildabzug. Jeder Sensor rauscht und keine Sensor ist Fehlerfrei! Grob gesagt gibt es neben dem Rauschen, dass der Ausleseprozess verursacht, ein zufälliges Rauschen sowie "heiße" und "kalte" Pixel. Das sind Pixel, die einfach extrem hell sind oder eben solche, die kein oder zu wenig Signal zeigen, Fehlstellen also. Diese Fehlstellen kann man durch die Funktion "Pixel Korrektur" die man im Menü der Kamera findet, softwaremäßig lahm legen. Ist sicher heikel diese Funktion und sollte man wohl nur wirklich anstoßen, wenn man wirklich sicherstellt, dass während der Messung kein Licht auf den Sensor gelangen kann. Ob die Kamera zerstört wird, wenn da während der Messung Licht draufällt und die dann als "Fehler" mit ausgeschlossen werden, keine Ahnung, will ich nicht testen. Ich mache das maximal wenn ein Hotpixel unangenehm auffällt und stört. Kommt aber sehr sehr selten vor. Was auch sehr lästig sein kann: Sensor glühen Da kommt es üblicherweise auf das Design der Kamera selbst an, da sind wir üblicherweise zum Glück bei den heutigen Olympuskameras nicht betroffen. Es kommt z.B. von Leiterbahnen oder sonstigen Wärmequellen, die vielleicht an einer bestimmten Stelle den Sensor stärker erwärmen. Das Bild wird dann an einer Stelle deutlich mehr Rauschen. Je höher die Temperatur, Verstärkung (ISO) und je länger die Belichtungszeit, desto mehr rauscht es. Mit der üblichen Einstellung AUTO ist man an sich gut bedient. Die Kamera macht dann bei längerer Belichtungszeit (so ab 1-2 Sekunden) eine zweites Bild bei geschlossenem Vorhang. Genauso lang wie das vorhergehenden "normal" Bild (=light frame). Dieses Bild ohne Licht nennt sich Dunkelbild oder Darkframe. Es enthält damit das Rauschen des Sensors, bei den selben Einstellungen (ISO, Temperatur und Zeit) des eigentlichen Bilds (Light) und wird dann in der Kamera abgezogen. Das entstandene Bild wird dann als ORF geschrieben, ins JPG sowieso. Das kostet natürlich Zeit. Solange man jede Menge Zeit hat und nur kurz Belichtet oder man sich hinterher mit sonst nichts auseinandersetzen will, ist es das Mittel der Wahl und stimmt naturgemäß am besten. Gerade bei DeepSky ist aber die Zeit am Himmel oft sehr eingeschränkt und will bestmöglich genutzt sein. Daher wird man diese Dunkelbilder dann lieber selber anfertigen und später extern abziehen. Ich mache Darks zwischendurch, wenn Wolken durchziehen, meist aber wenn ich alles abbaue: Objektiv abecken und bei den selben Belichtungseinstellungen wie die Lights: Also selbe ISO, Zeit und Temperatur und Belichtungseinstellung wenn z.B. der Livetimemodus verwendet wurde. Nur dass halt kein Licht auf den Sensor gelangen kann. Unsere Olympus Kameras sind da recht gutmütig. Achtung: Manche Objektivdeckel schließen nicht gut, z.b. das des mFT8/1.8 wo man auf wirklich korrekten Sitz achten muss. Da man das meist sowieso draußen in der Nacht macht sicherheitshalber die Darks an einer dunkel Stelle anfertigen. Wenn man in etwa die selben Bedingungen schaffen kann, kann man die Darks auch später nachmachen. Bei manchen Kameras wird die Temperatur in die EXIF Daten geschrieben und zB. einem EXIF Programm wie ExifToolGUI auslesen. Man kann auch eine Bibliothek anlegen mit seinen Darks bei unterschiedlichen Temperaturen/ Belichtungszeiten / ISO und die verwenden. Wenn sie aber nicht mehr zu seinen Lights passen, weil sich auch Sensoren ändern, dann muss man Neue anfertigen. Solange es aber so "billig geht", wie einfach einige am Ende der Session, mache ich das nicht. Es hilft auch für jede Session genauer die Eckdaten zur Belichtung und Bedingungen wie Temperatur mitzuschreiben. Dann hat man sie vielleicht in der Not zu Hand. Früher oder später wird man aber auch Flat und BIAS Korrekturen machen wollen, denn sie berücksichtigen andere Bildfehler und schaffen so die Grundlage für eine wesentlich fehlerfreieres Bild. Rauschfilter Das ist nichts anderes als eine softwaremäßige Entrauschung. Normalerweise steht sie bei mir auf Aus oder Niedrig. Da man aber sowieso mit dem RAW arbeitetet ist es egal, denn diese Bearbeitung wird nur ins JPG geschrieben. Klar sieht ein Bild am Computerschirm immer sehr schlimm aus, kann man es ja beliebig vergrößern, aber wenn das Motiv passt, wird sich keiner am Rauschen stören, bei den üblicherweise am Internet gezeigten kleinen Bildern schon gar nicht. Beste "Eigentherapie": Ausbelichten lassen und beim richtigen Betrachtungsabstand ansehen 🙂 Entrauschen kostet, wenn man es nicht selektiv macht, immer Details. Gerade im dunklen Hintergrund wird man kleine Galaxien und Strukturen entsorgen. Durch das Zusammenrechnen vieler Bilder wird das Rauschen sowieso erheblich reduziert. Bei einigen Sony Kameras kam es 2016 mit einem Firmewareupdate dabei zu einem weiteren Problem: Die Kamera eliminiert kleine Sterne weil sie sie als Rauschen erkennt. Dieses Problem ist als "Star Eater" bekannt und dazu gibt es unzählige Artikel. Ich hoffe, dass uns Olympus weiterhin die Möglichkeit lässt, an eine möglichst unverfälschtes Rohbild zu kommen ! -

methodik Scharfstellen

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

Das es viele verschiedene Faktoren gibt, die einem Fehlbilder bringen und so eine der oft seltenen wirklich guten Nacht kosten könnte, überlasse ich da wo ich etwas selbst beeinflussen kann, nichts dem Zufall. So auch beim Scharfstellen Bei der E-M1 mark III gibt es zwar diesen Sternen AF, zwischenzeitlich (RTFM 😉 ) bekomme ich das aber gut hin (größerer Cluster an Focusfeldern). Wenn man sich einen Stern in ganz großer Vorschau ansieht kann man zusehen, wie die Kamera scharfstellt (intra/extrafocal). Bei längerbrennweitigen Objektiven (so ab 75mm) habe ich den Eindruck, dass ich besser manuell scharfstellen kann. Bei unter 25mm ist der StarryAF ein Segen. An Planeten wie Mars, Venus geht es auch mit dem lichtschwachen mFT100-400er. Es müssen halt möglichst punktförmige Objekte sein. Trotz hilfreichem StarryAF ist es aber immer angebracht anhand eines Bildes mal den Fokus zu überprüfen. Außer mit starkem Teleobjektiv am Mond verlasse ich mich da nie auf den Autofokus. Schon im Hinblick darauf, dass man ja üblicherweise nicht ein Bild sondern sehr sehr viele macht und die wirkliche Bildqualität dann erst hinterher am großen Computermonitor sieht, stelle ich lieber manuell scharf ein. Die Funktion "Objektivrückstellung" schalt ich bei dem Kameras die ich meist für Astrofotografie verwende aus. Oft will ich eine Belichtung unterbrechen, was ich dann einfach durch Ausschalten der Kamera mache, anstatt Minutenlang zu warten. Dann ist es nützlich, dass die Schärfen ebene des Objektives bleibt wo sie ist. Zunächst muss man aber überhaupt mal einen hellen Stern am Kameradisplay finden, was bei einem stärkeren Fehlfokus schon meist nicht mal möglich ist, weil das schwache Licht ja über eine große Fläche verteilt ist, und so nicht mal mehr angezeigt wird. Bei dem heutigen OM-D's gibt es mittlerweile eine LiveView Erweiterung II. Man sieht da dann wirklich sehr viele Sterne (aber auch Hotpixel!). Die Verzögerung macht es aber schwierig damit scharf zu stellen. Hat man den Fokus wirklich getroffen, sieht man auch den einen oder anderen schwächere Sterne im LiveView Modus I. Man kann mal zuerst an einer möglichst weit entfernten Lichtquelle mal vorläufig scharf zu stellen oder auf eben, wenn man hat, LV Erweiterung II zu schalten. Der ist zwar verzögert, aber so lichtstark, dass man schon recht schwache Sterne sehen kann, Helle dann sowieso. Um schnell von LV Erweiterung I auf II zu schalten kann man sich da bei den neueren Kameras im Menü es so einrichten, dass man der "Restlicht" Modus ab 60 Sekunden zugeschaltet wird, sonst aber auf LV Erweiterung I bleibt. Dann braucht man nur schnell von 60 Sekunden auf Bulb oder Livetime zu schalten. Die E-M1.III hat eine extra Einstellung für Bulb/Livetime am Modusrad. Wo man dann halt am Modusrad drehen muss, beim M habe ich jetzt auf die Schnelle nicht gefunden, wie ich da über 60s einstellen könnte. Egal. Dann einen möglichst hellen Stern in die Bildmitte bringen und mit Liveview Vergrößerung (14x) so fokussieren dass der Stern so klein wie möglich ist. Der MF Assistent im Kameramenü ist dazu ausgeschaltet, aber ich lege mir auf eine Funktionstaste die Vergrößerungsfunktion. Ein Klick auf OK verlässt dann wieder den Vergrößerungsmodus. Bei starken Teleobjektiven gibt es eine Einstellhilfe inform einer speziellen Maske, die man vors Objektiv gibt: Die Bahtinovmaske Das beigefügte Bild zeigt den Effekt an einem 135mm Objektiv und dem sehr hellen Stern Capella. Bei Brennweiten unter 60mm wird es dann halt schwierig, zu klein werden die Sterne. Bei Modifizierten Kameras sieht man aber auch da den roten Saum recht gut den ich mit dem Stern zu vereinigen suche. Vorsicht bei Temperaturänderung: Üblicherweise verstellt sich der Fokus wenn sich die Temperatur ändert. Die Tuben sind aus Metall, Linsen ändern sich wohl auch. Ist das Objektiv wesentlich wärmer als die Umgebung oder kühlt es dann weiter stark ab (üblicherweise in klaren Nächten), sollte man unbedingt vor allem Anfangs alle 5-10 Minuten den korrekten Fokus kontrollieren. Wenn geht, daher schon vorher an die Umgebungstemperaturen abpassen lassen. Wenn man Glück hat ist in der Nähe der Bildmitte ein heller Stern an dem man zwischendurch mal schnell den Fokus kontrollieren kann. Ansonsten kann das es sehr aufwendig werden, den Fokus zwischendurch mal an einem geeigneten Stern außerhalb des Bildfeldes zu überprüfen, weil man ein mühsam gefundenes Bildfeld möglichst genau (Stichwort: Stackingränder) wiederfinden muss. Da hilft eine "GoTo" Astromontierung, kann aber auch heikel werden - wenn man so gar nichts sieht, weil man keine LV Erweiterung II hat, wie bei den E-PLx Kameras, oder älteren E-M10. Einzig ein Spiegelteleskop mit dem richtigen Spiegelmaterial (Pyrex oder besser Quarz, jedenfalls kein PK7 Glas!), einen Kohlefasertubus und sehr guten verschraubten Okularauszug bleibt hier wirklich fokusstabil. Zumindest merke ich da bei meiner Ausrüstung nichts an den Bildern. Und schon aus Paranoia kontrollierte ich schon ofter hinterher nochmals ob der Fokus auch noch stimmt. Wie immer: Kostet um einiges mehr, aber erspart sehr viel Ärger. Bei Objektiven mit manueller Blende nicht vergessen, vorher die Blende ganz zu öffnen. Geht das alles nicht befriedigend, kann man anhand von Probebildern den Fokus überprüfen und gegebenenfalls neu einstellen, alles sehr Zeitaufwändig. Am Mond ist es am besten in der Nähe des Terminators scharf zustellen, Am Jupiter sieht man die Galileischen Monde , die recht schnell verschwinden sollte der Fokus nicht mehr recht passen. Verwendet man eine Modifizierte Kamera, wird man um helle Sterne einen roten Saum sehen, weil das viele langwellige rote Licht ja nicht mehr in den Fokus zu bringen ist, wenn gleichzeitig blau und grün scharf sind. Der optimale Fokus ist dann, wenn dieser rote Saum genau verschwindet. Schärfeverlauf / Sensorverkippungen: Wir sind an sich von unseren sehr guten Fotooptiken verwöhnt, aber gerade wer Fremdobjektive oder Teleskope verschiedener Bauart an der Kamera anschließt, sollte beachten, dass man hier oft mit starken Abweichungen der Schärfe übers Bildfeld und/oder Verkippungseffekten hat. Wenn bei einer Optik die Schärfe stark zwischen Zentrum und Rand abweicht, dann kann es günstiger sein, nicht in der Mitte, sondern ca. 1/3 herum scharf zu stellen. Damit minimiert man dieses Ungleichgewicht. Wer mal einen hellen Stern möglichst groß ansieht und Fokussiert, sollte im Bildzentrum bei Intra- und extrafokaler Betrachtung (einfach wenn man über die Schärfe in beide Richtungen hinaus fährt) alles zentrisch sehen. Das Sternchen wird ja zur Scheibe und je nach Bauart sieht man dann hellere konzentrische Ringe. Ist hier etwas verkippt, wird dieser Kreismittelpunkt nicht genau konzentrisch sein, sonder außerhalb des Zentrum liegen. Am Rand bei den Optiken bei kleineren Brennweiten wird man staunen, wie sehr man da sieht, dass Sterne fast dreieckig abbilden. Solange das in jeder Ecke gleich aussieht, wird alles in Ordnung sein. Anders wenn es in den Ecken ungleichmäßig wird. Dann ist entweder die Optik dezentriert und/oder Sensor verkippt. Bei unseren Olympus Kameras meist nach Modifikation. Je lichtstärker eine Optik, desto deutlicher treten diese Fehler zu Tage. Daher sind Fernrohre ab F/5-F/6 natürlich wesentlich gutmütiger was Justierung betrifft. Ein Test an einer punktförmigen Lichtquelle, wie man es praktisch nur an Sternen hat, verbergen nichts was optische Fehler betrifft! Allerdings für die Alltagsfotografie hat das wohl zunächst kaum sichtbare Auswirkungen, durch Stacken / Mitteln viele Bilder und nachfolgender Bearbeitungsschritte kann man auch einiges korrigieren. Für Verkippungen an einem Teleskop gibt es eigene Ringe, womit man das dann ausgleichen kann. Gerade bei Fernrohren hat man zwischen Teleskop und Kamera noch sogenannte Flattener oder Komakorrektoren. Die sollen die Fehler der entsprechenden Optik ausgleichen. Hier ist es wichtig herauszufinden, ob der Flattener überhaupt für die Bauart seines Teleskopes geeignet ist. Da zählt nicht nur Bauart (APO oder Newton z.B.) sondern auch deren Lichtstärke. Und man muß dann den geeigneten Abstand zwischen den Flattener und dem Sensor herausfinden. Ob man dann zu weit oder zu nahe ist, zeigen einem Striche oder Banananförmige Sterne gegen den Bildrand. Und ob man dann etwas mehr Zwischenringe geben muss oder weniger kommt auf das Teleskop an. Man sieht: Sobald man die normierte Fotowelt verlässt, wird es sehr kompliziert und gleich mal teuer. Gute Comakorrektoren kosten gerne mal ab 200 - sehr sehr viel mehr! Es gibt übrigens einen Vorteil, bewusst unscharf zu bleiben: Wenn man kein Weichzeichenfilter hat (Cokin P830) und man will den Sternenhimmel so abbilden, dass helle Sterne und damit die Sternbilder natürlich zu erkennen sind, kann man leicht unscharf stellen. Damit wird das Licht sehr heller Sterne über eine größere Fläche verteilt. Sie brennen dann nicht sofort aus und man sieht dann auch noch schön deren unterschiedlichen Farben, die über die Temperatur Aufschluß gibt. Bei gut scharf gestellten Sternen Himmel werden ja bei den üblicherweise längeren Belichtungszeiten ja alle hellen Sterne aber auch etwas schwächere Sterne sofort ausgebrannt, verlieren damit die Farben sein und das Auge sieht nur noch weiße Punkte auf schwarzem Grund. Da finden sich bald nur noch sehr Geübte zurecht. Hier ein Ausschnitt unbearbeitet mit dem mFT8/1.8 möglichst selber Ausschnitt durch ein Cokin P830 Weichzeichenfilter: -

methodik Dateiformate

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

JPG, ORF oder gar Video? Ganz einfach: ORF ! Wer bei gutem Licht und gleichmäßiger Ausleuchtung fotografiert findet ja üblicherweise mit dem Standard Bildformat JPG sein Auslangen. Leichte Korrekturen sind da noch möglich, aber sobald es darum geht, stärkere Farbkorrekturen oder aus sehr dunklen Stellen was ins Helle zu dringen, wird man sich wünschen auf ein RAW file zurückgreifen zu können. Bei Olympus sind das die ORF Dateien. ORI bei speziellen Modi ist auch nur ein ORF und kann man umbenennen. Wahrscheinlich kann man sich bei recht vollem Mond, wo es auch kaum Kontraste gibt, leisten mit JPG zu fotografieren. Sobald man aber versucht dramatische Wolkensituationen mit ins Bild zu bringen, wird man die nur noch am ORF herauskitzeln können. Bei dem hellen Vollmondlicht wird selbst das nicht gelingen, zu stark ist der Kontrast. Aber wenn man eine Situation hat, wo das Mondlicht zusätzlich durch Wolken stark gedämpft wird, kann man durchaus nette Bilder bekommen: Warum ist das so? Ein Farbbild besteht aus Pixel, die den 3 Farben: R(ot) G(rün) B(lau) zugeordnet werden. Das bekannte RGB Bild. Wie hell jetzt ein Pixel ist wir dann in der computerüblichen Diktion beschrieben. Die kleinste Einheit ist 1 Bit und hat entweder den Wert 0 oder 1. Für ein reines Schwarz/Weiß Bild reicht also 1 Bit an Information. Daher sind solche Bilder so klein. Man muss nur die Anzahl der Pixel x 1 Bit pro Pixel für die Helligkeit speichern. Ein JPG Bild benützt für jedes der 3 Farbpixel 8 Bit um die unterschiedlichen Helligkeitswerte abzubilden. Mit 8 Stellen 0 oder 1 kann man einen Wert von maximal 256 abbilden (2^8). 0 = schwarz 256 ist gesättigt. JPG hat also je Farbkanal 256 Abstufungen und 256x256x256 ergibt die große Zahl 16,77 Millionen unterschiedliche Farbtöne. Ist auf jeden Fall genug für die Anzeige. Die Elektronik und Sensoren der derzeitigen Olympus Kameras können die Werte des Sensors mit 12 Bit Auflösung ausgelesen. Und das findet sich in den RAW/ORF Files wieder. 2^12 sind 4096 Abstufungen je Farbkanal. Und das brauchen wir, wenn man in den dunkelsten Stellen noch brauchbare Bildinformationen herausholen will. Eines darf auch nicht verschwiegen werden: Das JPG Format ist ein verlustbehaftetes Format. Wie hoch der Verlust ist, hängt von der Einstellung ab, die man trifft. Dabei werden bevorzugt Werte eliminiert, die unser Auge im bestehendem Bild kaum unterscheiden kann. Dumm nur wenn man die dann hinterher herausholen wollte, dann sieht man die Kompressionsartefakte und es ist nicht mehr viel da, das man hervorholen könnte. Video, soweit mir bekannt, ist bei Olympus Kameras immer verlustbehaftet. Wo man es aber versuchen kann wäre bei Mond, Planeten, Sonne wo man besonders viele Bilder in möglichst kurzer Zeit sammeln will, um das Luftflimmern zu minimieren. Da man also möglichst keinerlei der mühsam eingefangenen Daten am Sensor verlieren will, wird man also RAW bevorzugen. Es ist das unveränderbare Original, das von der Kameraelekronik erzeugt Bild und hier wird nur ein eventuell kamerainternes Dunkelbild abgezogen. Weißabgleich, Entrauschen und sonstige Spezialeffekte werden lediglich als „Vorschlag“ für einen spätere Entwicklung hinterlegt, aber hatten noch keine Möglichkeit unser ORF zu verunstalten. RAWs sind ja kameraspezifische Formate und zur bestmöglichen Entwicklung braucht es angepasste Software . Leider lassen sich da die Kameranetwickler nicht in die Karten schauen. Olympus hat bald mal begonnen, die ORF verlustfrei zu komprimieren, darum sind sie relativ klein. Es gibt aber auch Freeware RAW Entwickler Module wie derzeit das derzeit meist verwendete LibRAW, worauf auch viele Programme zurückgreifen. TIFF: Ein sehr altes, aber daher sehr universelles Format, dass ohne Verlust 16bit Bilder speichern kann bietet sich deshalb zumindest als Austauschformat an. Da es aber nur von allen anderen Programmen gelesen werden kann, wenn keine der vielen möglichen Kompressionen angewendet wurde, sind Bilder aber recht groß. Wir erinnern uns: Ein Bild wird dadurch beschrieben dass man die Anzahl der Pixel * Farbtiefe (16bit) speichern muss. Wer z.B. ein JPG Bild mehrmals bearbeiten und speichern muss, verliert immer etwas an Information. Ob man das sieht ist natürlich eine Frage des Anspruchs. Da wäre dann auf jeden Fall angebracht sein Bild als TIFF zwischen zu speichern. Da TIFF variabel gestaltet ist wäre ein 8/24bit (3x8bit) TIFF für JPG ausreichend. Damit verliert man bei jedem Speichern zumindest nichts durch Kompression. Wer also Bilder in seiner „Lieblings Software“ verarbeiten will, kann mal mit einem beliebigen Programm sein 12bit ORF als 16 bit TIFF speichern. Dann findet man alle Daten unverändert im seinem TIFF Bild. Es bedarf dazu keinerlei Kaufprogramme! Sobald man allerdings wirklich tiefer in „Deep Sky“ Astrofotografie einsteigt, wird man beim Stacken direkt die RAW Dateien verwenden. Da liegen die Daten nämlich noch linear vor und mit den „ungestreckten“ Daten sind einige, aber wesentliche Verarbeitungsschritte um einiges leichter (für die Software) zu machen. Linear/ungestreckt - Was ist dass denn wieder? Betrachten wir den Wert der Helligkeit, den ein Pixel gerade am Sensor hat: So liegt (weitgehend) ein linearer Zusammenhang zwischen der Anzahl der Lichtteilchen und dem ausgelesenen Helligkeitswert vor: Also doppelt so viel Licht ergibt einen doppelt so hohen Wert für die Helligkeit. 4 x mehr Licht, 4x höherer Wert... Wir sprechen dann von linearen Daten und wenn man damit arbeitet, eben im linearen oder ungestreckten Zustand. Um es vorwegzunehmen: Lineare Bilder sind, zumindest bei 12 Bit, an sich schwarz am Bildschirm. Daher werden sie durch Fotosoftware bei der Entwicklung gestreckt, also delinearisiert. Das ist das was man herkömmlich gewohnt ist und dem entspricht wie unsere Augen und der „Prozessor“ dahinter arbeitet. Ein Pixel das doppelt so hell ist, ist es nachher z.b. 4x so hell. Diese Kurve, kann man dann eben ein wenig beim Entwickeln beeinflussen. Wer also photometrische Auswertungen, also das Messen von Helligkeiten machen will, wird nur linear arbeiten, denn wenn man nicht weiß, wie der Streckalgoritmus genau funktioniert hat, kann man nicht zurückrechnen. Aus demselben Grund ist es auch einfacher, Bearbeitungsmodule für lineare Bilder zu schreiben, denn bei gewissen Funktionen müsste man wissen, wie ein Bild genau gestreckt wurde weil ja kein einfacher linearer Zusammenhang zwischen Helligkeit und Signal mehr besteht. So gibt es bei sehr fortgeschrittenen Programmen (PixInsight, Siril) eben Programmmodule, die nur im Linearen Bereich arbeiten oder im gestreckten, aber auch Module, die in beiden Welten angewendet werden können. Weil es hier auch passt und warum man bei DeepSky mit RAW-Entwicklern wie LR nicht weiterkommt: Solange man die Datenwerte, die das Bild beschreiben nicht beschneidet, kann man dieses um arrangieren wie immer man will. Am schnellsten fällt einem das auf, sobald man einen mehr oder weniger großen (meist aber mehr 😉 ) Farbstich im Bild hat. Keine Panik !!! es ist mal völlig egal, denn solange alles an Werten, die die Pixel beschreiben da ist, kann man hinterher das beheben. Damit nichts (versehentlich) beschnitten wird, ist es wichtig, immer sehr genau auf sein Histogramm zu sehen, wenn man da etwas ändert. Das Histogramm zeigt ja die Verteilung der Helligkeiten unsere Pixel im Bild. Am linken Ende der dunkle Bereich und rechts der helle Bereich. Wer dann eben oben (heller Bereich) oder unten (am dunklen Ende) etwas verschiebt, sollte hier nichts wegschneiden. Idealerweise zeigt das Programm genau an, wie viel man an Informationen wegschneidet. Da stößt man bei Photoshop derzeit noch immer nicht genau wie viel das ist, bei PixInsight (vielleicht auch der Freeware Siril mal oder kann es bereits?) sieht man auch wie viele Pixel man genau opfert, nicht nur %. Klar, 10-50 Pixel kann man schon mal opfern, wenn man 20 Mpixel hat, aber was weg ist ist unwiederbringlich verloren. Und man beschneidet natürlich auch, wenn man die Farbtiefe reduziert. Also von z.B. 16 bit oder 12bit auf 8 bit wie sie bei JPG zur allgemeinen Verwendung gebräuchlich sind, geht. Man kann ja die vielen Werte nicht mehr mit weniger bit abbilden und muss sie zwangsläufig „zusammenstreichen“. Ein Zurück ist da nicht mehr, man könnte nur fehlende Zwischenwerte künstlich durch Interpolation schaffen. Wenn unser Kameras nur 12 bit Auflösung bieten, warum haben wir jetzt mehr als 12 Blenden Kontrastumfang ? Das liegt daran, dass der Sensor und die Ausleseelektronik eben so gestaltet wurde, dass er vor allem im oberen Bereich einfach nicht mehr ganz linear abbildet. Je mehr Licht, desto etwas weniger Signal wird dann „produziert“. Die hellen Stellen brennen dann nicht ganz so leicht aus. Hier ist auch der Vorteil von 14 oder 16 bit Sensoren, die jetzt immer mehr verfügbarer werden zu sehen. Jetzt rein rechnerisch betrachtet (ohne auf spezifische Sensoreigenschaften einzugehen): Bei einer 14 Bit „Kamera“ kann man 4x so lange belichten bis ein Pixel gesättigt (der maximale Wert der abgebildet werden kann) ist als bei einer 12 Bit Kamera. Denn der Werteraum von 12 Bit reicht nicht aus. Belichtet man bei 12 Bit doppelt so lange (doppelt so viel Licht) muss einen doppelt so hohen Wert abgespeichert werden können als bei 12bit, das geht nur, wenn man mindestens 13 Bit zur Verfügung hat. Und wenn man nochmals doppelt so lange belichten will, braucht es dann eben 14 Bit um den Wert abzubilden. 2^14 sind übrigens 16384 Helligkeitswerte die ein Pixel annehmen kann. Aber auch die reichen nicht um den unheimlichen Kontrastumfang zwischen Sternen und Deep Sky Objekten abzubilden. In der Praxis brennen hellere Sterne unter einer Sekunde aus für den Rest sind dann 4 Minuten angesagt. Nur an besonders hellen Objekten wie die Andromeda Galaxie oder noch extremer: Orion Nebel, kommt einem das dann natürlich sehr gelegen, weil man sich zwingende unterschiedliche Belichtungsreihen einsparen kann. Aber um den Unterschied den 14 Bit gegen 12 Bit dann bei der eigenen Ausarbeitung noch zu nützen, bedarf es schon sehr viel Erfahrung in der Bildbearbeitung. Da liegen die Hürden über längere Zeit wohl ganz wo anders. Abhalten sollte uns dieser Unterschied jedenfalls nicht.-

- 1

-

-

- astrofotgrafie

- orf

-

(und 2 weitere)

Markiert mit:

-

methodik Flat / BIAS - Bildkalibration

iamsiggi hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

So wie kein Bildsensor Fehlerfrei ist, ist es auch der gesamte optische Weg nicht. Auch hier gibt es Möglichkeiten, sein Bildmaterial zumindest von solchen Einflüssen zu bereinigen. Gemeinhin spricht man dann von der „Bildkalibrierung“ und dazu werden neben dem Dunkelbild auch Flat und BIAS Bilder gebraucht. Wer wird das brauchen: Alle die Wert auf höchste Details legen und Artefaktfreie Bilder wollen. Daneben aber erleichtern sie die Bildbearbeitung. Also alles was Deep Sky betrifft. Landschaftsfotografen, die eine sichtbare Vignette aus dem Bild bekommen wollen sollten auch mal probieren. Solange die wirklich konzentrisch ist, geht das auch Softwaremäßig, aber eben nur Helligkeitsverläufe, keine weiteren sonstigen Fehler. Wer wahrscheinlich nicht: Kaum wird man das bei Bildern des Mond und Planeten brauchen, solange es bei Großen Bildern um „schöne“ Bilder geht oder bei kleinen hellen Planten. Die nehmen ja am Sensor nur wenige Pixel ein und man wird den Rest stark beschneidet. Solange man da nicht irgendwelche Artefakte wie Vignetten (Helligkeitsabfälle) oder Reflexionen etc. bemerkt, die man einfach wegstempeln könnte, weil der Bildhintergrund sowieso schwarz ist. Was ist nun ein Flat: Einfach ein gleichmäßig ausgeleuchtetes Bild beim selben Lichtweg wie sein Hellbild (Light). Also selbe Blende, selbe Schärfeneinstellung und wer die Kamera zur „Optik“ rotieren kann (also mehr an Teleskopen) dieselbe Ausrichtung. Was korrigiert ein Flat: . Vignetten (Helligkeitsabfall der Optik) . Staub auf dem Sensor (bei Olympus mit dem effizienten Staubschüttler meist nicht so das Problem) . Unterschiedliche Empfindlichkeiten von Pixel . Reflexionen im gesamten Strahlengang Was macht es mit unserem Bild: Vereinfacht gesagt: Da wo ein Pixel zu wenig Signal zeigt wird es auf heller gerechnet, da wo es zu hell ist dunkler. Wie macht man es: Bei welcher ISO ist nicht so entscheidend weil es ja nur um den Helligkeitsverlauf geht. Gerne bei optimaler ISO, bei uns also ISO 200. Wer allerdings öfter vergisst, nachher bei Darks wieder die ISO auf den Wert seiner Lights anzupassen, kann auch die selbe ISO wie die verwenden. Was allerdings wichtig ist: Man belichtet Flats so hell wie möglich, aber im linearen Bereich des Sensors. Das wird ca. bis +1,7ev sein, aber +1 Blende drüber (Automatik) funktioniert da auch. Daher verwende ich jetzt einefach +1ev (Blende). Unterschiedliche Astrokameras können das schon sehr anders reagieren. Manche brauchen dann FlatDarks etc. Unsere Sensoren der derzeit gängigen Olympuskameras (16 / 20 MPixel CMOS) sind bislang sehr gutmütig. Ob ein Flat jetzt mit Automatikbelichtung, einer Blende heller oder 1,7 Blenden heller belichtet ist, spielte bei mir zumindest derzeit keiner Rolle. Flats kann man auch später nachmachen: Man muss nur die selben Einstellung (Fokus/Blende und Rotation) nachstellen. Ein Problem kann jetzt sein, wie man eine wirkliche gleichmäßige Beleuchtung sorgt. Da habe ich einfach eine Flatbox von Lacerta/Teleskop Austria für mein 200mm Teleskop besorgt, die um vieles besser als die EL-Folien sind. Wichtig jedenfalls: Die Verschluss Zeit sollte länger als ein eventuelles Flimmern sein. Bei EL-Folien mehr als 1/50 bei meiner gibt es bis unter 1/500 kein Problem. Eventuell seine Flats hinterher durchsehen, ob sich etwas an der Ausleuchtung änderte. Sei es durch Flimmern oder dass Verschluss Lamellen manchmal Teile des Bildfeldes verdunkeln. Bei sehr lichtstarken Geräten und hochempfindlichen Kameras kann die Belichtungszeit ein Problem werden. Bei unseren Fotoapparaten hatte ich da bislang keine Probleme. Daneben gibt es verschieden Methoden, wie man für die gleichmäßige Ausleuchtung sorgen kann, die aber alle etwas aufwändig sind. Stichwort: Dome Flats (eine große weiße Fläche in der Sternwarte die man dazu verwendet), Sky Flats, Dämmerungs Flats (man benützt den Himmel). Am praktikabelsten vielleicht noch die T-Shirt Methode (ein T-Shirt/Stoff am Tag über die Optik). Ein gutes gleichmäßig ausgeleuchtetes Leuchtpult, sollte auch funktionieren. Laptopbildschirme sind meist nicht exakt ausgeleuchtet, daher kaum mehr in Gebrauch. Kann man aber probieren. Ist etwas zu hell, kann man mit weißem Papierlagen die Intensität dämpfen. Es versteht sich aber, das Papier oder Stoff zur Lichtreduktion keine Falten oder andere Strukturen aufweisen darf, denn es würde dann Strukturen ins Bild einbringen. Am einfachsten aber wie schon geschrieben: Ein passende Flatfield Box. Bei extremem Weitwinkel wie 8mm wird es aber schwierig, da noch ein Flat „bis zum Rand“ zu erstellen. Bei diesen weiten Winkeln geht es sowieso kaum mehr um letzte Präzision, zumindest am Rand. Wie gehe ich vor: Am Ende / Anfang der Session halte ich die Flatfield Box vor die Optik. Einfach auf automatische Belichtung (bei Fotoobjektiven mit Automatischer Blende im A Modus, damit man die selbe Blende hat) mit +1ev (Blende) bei ISO200 oder der wie man die Bilder machte und dem Serienbildmodus Bilder sammeln. Meist werden es bei mir um die 30-50. Natürlich darf da nicht schon Tau auf den Optiken im Spiel sein !! Also alles ganz einfach und schnell. Was man allerdings für die Flats auch benötigt sind BIAS: BIAS oder Offset Frames Wer braucht BIAS: Jeder der Flat Files macht. Wer keinerlei Dunkelbild macht, kann so zumindest das BIAS herausrechnen. Wer nur einen Dunkelbild Abzug machte oder durch die Kamera machen ließ, braucht es nicht, denn das BIAS Signal ist ja enthalten. BIAS von einem Dark abzuziehen wäre eine Überkorrektur. Was ist das: Das Ausleserauschen und dem „Offset“ – ein Signal womit der Sensor „vorgeladen wurde“ damit er empfindlicher wird. Wie macht man es: Einfach ohne Licht die kürzest mögliche Belichtungszeit bei der ISO mit der man die Flats machte. Also „Dunkelbilder“ im S-Modus mit kürzester Belichtungszeit. Auch hier: Viele machen. FlatDarks: Ob man BIAS oder Flat Darks zur Korrektur der Flats nimmt, hängt von der Kamera ab. Je nach dem was am besten funktioniert. Ein Flatdark ist nicht anderes als ein Dunkelbild, das genauso lang wie die Flats belichtet werden. Da ist dann das Rauschen bei den Bedingungen drinnen, wie es im Flat auftritt. Und natürlich auch das unvermeidliche BIAS Signal. Man sollte es gehört haben und auch mal überprüfen ob man jetzt BIAS oder Flatdarks nehmen sollte. Für CMOS Kameras wird Flatdark empfohlen, nach langem probieren verwende ich jetzt statt des BIAS jetzt einfach FlatDarks. Geht bei all meine Olympuskameras genauso gut! Warum braucht man viele „Korrekturbilder“ wie Darks/Flat/BIAS Man kann nur Sachen korrigieren, die immer gleich bleiben, also systemspezifisches. Dazu kommt aber auch immer ein zufälliges Rauschen mit ins Bild. Dieses zufällige Rauschen würde aber wieder Rauschen ins Bild einbringen. Daher mittelt man möglichst viele Darks / BIAS / Flats zu sogenannte Master - Flats/BIAS/Darks. Wie beim Stacken auch, reduziert sich das Rauschen bei jeweils 4 Bilder auf die Hälfte. Daher wird es schon viel bringen so 10-15 Bilder zu machen, besser natürlich wenn man 30-50 hat (was bei BIAS/Flats ja leicht und schnell zu machen ist) und kaum mehr was, wenn man 150 oder mehr anfertigt. Man sollte nicht verschweigen, dass es auch Kalibrierungsartefakte geben kann. Das beste Mittel dagegen ist Dithering. Dazu wird nach jeder Belichtung das Bildfeld versetzt um einige Pixel, so dass nicht immer dasselbe Signal auf den selben fehlerhaften Pixel/Pixelbereich fällt. Auch Stackingalgorithmen tun sich leichter Ausreißer zu isolieren und so gar nicht erst zur Erstellung des Endbildes zuzulassen. Eines der augenfälligsten Dinge hier ist hier ein Effekt, der Astrofotografen, die Farbkameras verwenden trifft: wandernde Schatten/Rauschen (moving/walking shades/noise). Hauptursache ist meist ein Zeichen einer nicht genauen Nachführung, wo die Objekte gleichmäßig über sehr lange Zeit übers Bildfeld wandern. Das ist praktisch an sich so gut wie gar nicht mehr zu korrigieren: Warum braucht man das in der „Alltagsfotografie“ nicht ? Weil wir hier genügend Licht zur Verfügung haben. Am Sternenhimmel wird minutenlang bei hoher ISO Licht gesammelt. Alles sehr weit weg vom vorgesehen „Einsatzzweck“. Dazu kommt, dass sich die Objekte kaum vom Himmelshintergrund abheben. Da wir diesen winzigen Unterschied extrem hervorheben, wird man jeden kleinen Fehler ebenso stark hervorheben. Wir müssen lange belichten, damit sich zumindest dieser schwache dunkle Bereich schon in einem Helligkeitsbereich am Sensor befinden, der nicht mehr so unheimlich stark rauscht wie es Sensoren im dunklen Ende eben machen. Mit der Bildkalibration kann man relativ einfach einiges an Bildfehlern beheben, die uns das Leben bei der nachfolgenden Bearbeitung sehr erschweren bis unmöglich machen. Vertiefende Infos zum Thema Bildkalibration findet man bei Thomas, der bei einem Vortrag der Sache auf den Grund ging: Bildkalibrierung Frank (Astrophotocologne) in seinem youtubekanal hat auch einiges dazu. Nachtrag: Problemen mit Korrekturfiles ? Da hilft Pixelmathematik. FitsWork kann es ganz sicher (vielleicht Siril auch) natürlich PixInsight und Photoshop und sehr gute andere sollten das aber auch können. Ein schneller Test, wie sein korrigiertes "Light" aussieht wäre mit dieser Formel: (Light-dark)/(flat)*med(flat) Flats korrigieren nicht oder bringen unerwünschtes ins Bild: Einfach eine Division von 2 Flatbildern (oder eines davon Masterflat) also Masterflat/Flat. Wenn die nicht gleich gemacht sind (Kameradrehung und/oder Blendenänderung andere Brennweite etc.) wird man in der gleichförmigen hellen Fläche Strukturen sehen. Gernerell bei Bildern: Bild1 - Bild2 zeigt das, was unterschiedlich in den 2 Bildern ist. Ergänzung off Topic: Die Seismologen haben jetzt im Lockdown gerade die wohl einzigartige Gelegenheit herauszufinden, wie hoch der Anteil an künstliche Quellen in ihren gemessenen Erdbewegungen sind. Die Beben sind in manchen Gegenden (am meisten in Deutschland an der Zugspitze) stark zurückgegangen. Jetzt kann man auch kleinste Beben finden und in Zukunft wohl das starke Rauschen durch Korrekturen glätten. Wird z.b. Anwendung finden bei der Bohrung nach Erdwärme im Raum München, die ja überwacht werden müssen. Kleinste Änderungen, die unter normalen Umständen überhaupt im Rauschen untergehen, kann am dann vielleicht doch nachweisen. Auch die Seismologen an Meeresküsten habe ihre Freude: Mit dem Signal aus dem Meeresrauschen können sie jetzt noch besser die ersten 200km der Erdkruste beobachten. Siegfried-

- 3

-

-

-

- bias

- kalibration

-

(und 3 weitere)

Markiert mit:

-

methodik Fliegengittermaske nach Bahtinov im Eigenbau

Gast hat einem Thema gepostet in Astrofotografie's Hardware, Methodik und Software

Bahtinovmasken sind die Werkzeuge der Wahl für ernsthaftes Fokussieren. Meist fällt einem das ein, wenn kein freundlicher Hersteller oder Händler kurzfristig greifbar ist - nur das Internet, ein Baumarkt und etwa 12€. Aber das reicht für ein halbes Dutzend Masken. Wir brauchen: eine inspirierende Idee: http://www.astrotreff.de/topic…CHIVE=true&TOPIC_ID=88297 ein Teleskop oder Objektiv mit Streulichtblende ein Lineal einen Stift eine Schere eine Rolle Isolierband Sekundenkleber Hartschaumplatte oder ähnliches, 3-5mm dick und groß genug, um großzügig über dieStreulichtblende bzw. die Taukappe zu passen Fliegengitter, ungefähr doppelt so groß wie die Hartschaumplatte. Wenn Du die Auswahl hast, nimm das steifere. ein scharfes Messer (aus Sicherheitsgründen nicht abgebildet) Beim Fliegengitter brauchen wir zwei Teile, eines mit 0°-Winkel, eines mit 45°-Winkel. Es ist also eine gute Idee, den 45°-Teil etwas größer als den 0°-Teil zu machen. Schneide die Fliegengitterteile grob zu. Sei akkurat an den aneinanderliegenden Kanten der beiden Teile. Das macht es einfacher, die beiden Teile auszurichten und mit Isolierband zu fixieren. Als nächstes bauen wir den Rahmen. Ich habe die abgebildete Hartschaumplatte genommen - dickeres Material wird wahrscheinlich noch zuverlässiger halten. Mach den Rahmen merklich größer als die Streulichtblende bzw. die Taukappe, zentriere Teleskop oder Streulichtblende auf dem Rahmen und zeichne den Außendurchmesser auf dem Rahmenmaterial an. Schneide den angezeichneten Kreis minimal kleiner aus als angezeichnet und passe den Rahmen in kleinen Schritten an die Taukappe bzw. die Streulichtblende an. Klebe die beiden verbundenen Fliegengitterteile auf den Rahmen, schneide die überstehenden Ränder ab und klebe den Rahmen mit Isolierband ab. Es ist vollbracht - nach einer knappen Viertelstunde: Jetzt können wir das Werk testen. Defokussiert: Im Fokus: Die Vorteile der Fliegengittermaske gegenüber dem originalen Bahtinov-Design sind die deutlich geringere Obstruktion, die geringen Kosten und die einfache Bauweise. Ich hoffe, Ihr findet das irgendwie nützlich. E.- 2 Antworten

-

- bahtinovmaske

- bahtinov